Même après des années de travail dans le domaine de l'évaluation et de la méta-évaluation, il m'arrive encore de marquer un temps d'arrêt lorsque quelqu'un me demande : "Qu'est-ce que la méta-évaluation ? "Qu'est-ce que la méta-évaluation exactement... et comment bien la faire ?"

Méta-évaluation = évaluation de la qualité d'une évaluation.

Il s'agit du processus d'auto-réflexion et d'assurance qualité qui se cache derrière toute bonne évaluation, mais qui est souvent réalisé en coulisses.

Le problème ? Il est difficile de définir ce qui est "bon" et ce qui ne l'est pas, et c'est donc souvent vague, abstrait et difficile à communiquer.

Pour résumer - sans juger - les aspects les plus pertinents d'une évaluation, nous avons créé le "tableau de bord méta-évaluatif" qui révèle ce qui s'est passé pendant l'évaluation, en utilisant le rapport d'évaluation comme source.

Le tableau de bord présente visuellement les informations données dans le rapport sur les choix méthodologiques effectués.

Après une analyse approfondie et un processus de synthèse profond, les éléments les plus importants d'une méthodologie d'évaluation ont été sélectionnés.

Ce tableau de bord a été conçu pour être aussi générique que possible, mais il peut être personnalisé en fonction de vos besoins.

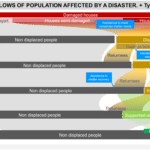

Évaluation de la complexité

Selon Patricia Rogers, la complexité - ou la simplicité - d'une intervention et de son contexte peut être définie par 7 éléments :

- Objectif - Y a-t-il des objectifs multiples (compliqués) ou des objectifs émergents (complexes) ?

- Implication - Y a-t-il plusieurs décideurs (compliqué) ou est-ce flexible et changeant (complexe) ?

- Cohérence - Existe-t-il une norme simple ou faut-il l'adapter au contexte d'une manière qui peut être identifiée à l'avance (compliquée) ou qui ne peut être connue qu'au moment de la mise en œuvre (complexe) ?)

- Nécessité - l'intervention est-elle le seul moyen d'obtenir les effets escomptés ?...

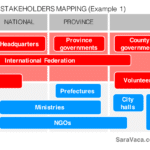

Analyse de la participation

Les rapports d'évaluation déclarent généralement avec fierté qu'ils ont suivi une approche participative.

Cependant, la participation comporte de nombreux niveaux et de nombreuses strates. Après avoir défini les principales parties prenantes susceptibles de participer à l'exercice d'évaluation, nous avons cartographié leur participation à chacune des phases de l'évaluation.

Les teintes plus foncées indiquent des niveaux de responsabilité ou de pouvoir de décision plus élevés.

Grâce à cette analyse de la participation, le tableau de bord peut montrer quelles parties prenantes ont été impliquées dans chacune des phases d' évaluation et dans quelle mesure elles ont effectivement participé (à titre principal ou simplement en tant qu'informateurs).

Analyse des méthodes mixtes

Pour cartographier les méthodes et techniques effectivement utilisées, le tableau de bord affiche le nombre de techniques utilisées dans chaque phase.

Elles sont affichées par rapport à l'ensemble du calendrier de l'évaluation, afin d'évaluer facilement la complémentarité de ces techniques et l'utilisation de méthodes mixtes (multi-méthodes) ou d'une seule méthode.

Cet exemple ne comprend que les icônes de certaines des méthodes les plus couramment utilisées, mais d'autres méthodes pourraient être utilisées et seraient indiquées en conséquence par leurs icônes.

Décisions d'échantillonnage

Presque toutes les études d'évaluation doivent prendre des décisions en termes d'échantillonnage, car il serait rentable d'atteindre l'ensemble de la population d'informateurs potentiels.

Pour donner une image quantitative de ces décisions, le tableau de bord recueille le nombre estimé de sources potentielles.

Ensuite, il reflète le nombre de chaque type de source qui a été finalement consulté par les évaluateurs. Enfin, il représente son %.

Il indique également s'il s'agit d'un échantillonnage raisonné ou aléatoire, comme d'habitude, selon le rapport d'évaluation.

Preuves crédibles

Par conséquent, pour évaluer la crédibilité des preuves trouvées, il convient d'adopter un ensemble de stratégies alternatives afin d'être raisonnablement sûr que les résultats reflètent la réalité.

Toutes ne sont pas nécessaires, mais l'ensemble doit être complémentaire et convaincant de la causalité ou de l'inférence causale.

Synthèse évaluative

Inspiré par Jane Davidson, c'est l'une des caractéristiques les plus uniques qui différencie une évaluation d'une étude de recherche.

La synthèse évaluative, entendue comme un jugement systématique, est l'essence même de l'évaluation.

De nombreuses évaluations le font dans une certaine mesure, en définissant les critères et les questions d'évaluation, mais des niveaux plus élevés de synthèse évaluative nécessiteraient de définir ce qui est "bon" dans chaque contexte particulier et les preuves qui démontreraient chaque élément, ce qui n'est pas si courant.

Source : Davidson, J. (2014) C'est le cœur même de l'évaluation et c'est ce qui fait la différence.

Normes d'évaluation

Un ensemble de normes et de codes de conduite a été compilé, définissant des aspects clés qui devraient être pris en compte et qui, en même temps, peuvent être facilement vérifiés en tant que comportements spécifiques.

Et voici le tableau de bord

La méta-évaluation (et les choix et conceptions méthodologiques) ne doit pas rester abstraite ou cachée dans des annexes techniques.

En la rendant visible, structurée et même belle, nous pouvons élever la qualité de nos évaluations - et des conversations qui les entourent.

Que vous soyez évaluateur, commissaire ou membre d'une unité d'évaluation, le fait de disposer d'un cadre visuel commun favorise la réflexion, l'apprentissage et la responsabilisation.

Ce tableau de bord n'est qu'un pas dans cette direction.

Créé en 2014, il serait intéressant de le mettre à jour aujourd'hui. Bien que je sois toujours fier d'en utiliser quelques-uns chaque fois qu'ils sont pertinents dans bon nombre de mes rapports.

💡 Si vous êtes curieux de savoir comment créer des visuels comme celui-ci pour soutenir votre pratique d'évaluation - je serais ravie de vous aider dans le cadre de mon [programme de mentorat 1:1].